BrendanHunter/iStock

進軍中の部隊が重要な都市まで迫った。だが兵士を突入させて、泥沼の白兵戦が展開されるような事態は避けたい。ならばドローンで守備兵を片付けておくか――。

テクノロジーの発達によって、かつては映画の中だけのものだった状況が現実になりつつある。今、各国の軍隊ではこうした自動技術に大いに興味を抱いている。

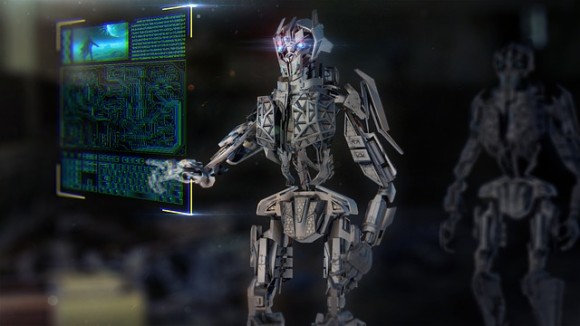

米軍が従軍している地域では、軍用ドローンがすでに空を飛行している。それはターミネーターのようなキラーロボットとは少々違い、発砲するかどうかは人間が決めており、完全な自律型致死兵器システム(LAWS)はまだ存在しない。

しかし、それを人間に代わって決定するアルゴリズムならある。カリフォルニア大学バークレー校のAI研究者スチュアート・ラッセル氏によると、LAWSは自動運転車よりも技術的に簡単であるらしく、2年以内にはかなり効果的な兵器が登場するだろうという。

スポンサードリンク

アルゴリズムによる自律攻撃

自律型致死兵器システム(LAWS)は、人工知能などが搭載されていて自律的に動き、標的を判断して殺傷する能力をもつロボット兵器を意味する。

攻撃を判断するアルゴリズムには、攻撃対象のリストが与えられており、カメラなどで捕捉したものが、かなりの確率でリストの対象であると判断されると攻撃に移る。

あるいは、過去の戦闘に基づき攻撃指示が下るだろうと判断される場合に攻撃するよう設定したり、戦場で銃を持った人間に攻撃するといったやり方もある。

ここ数年でAIは大きく発展したが、特に顔認証技術や物体認証技術はきわめて正確になった。これらはLAWS開発には特に大切な技術で、今それが不可能から現実へ向かって急速に動いていることを示している。

iStock

LAWSのメリット

攻撃の判断を完全に機械任せにしてしまうことには、恐ろしいほどの倫理的意味合いがある。それなのに、なぜそんなことをしようというのだろうか?

軍の立場からは、まったく新しい世界が開けると言える。たとえば、各ドローンを兵士一人一人が操縦しなければならないのだとすれば、それを大量に展開するにはそれだけ人員を割かねばならない。

また現在のドローンは基地と情報の送受信を行わねばならないが、それはタイムラグの原因となるし、万が一通信が遮断されてしまえば、まったく使い物にならなくなってしまう。

だがLAWSならそんな弱点はない。わずかな人員で大量に運用することが可能で、通信が遮断されて無力化してしまう心配もない。

従来の兵器よりも人道的?

さらに人道的であるという見方もできる。なにしろ生身の人間を過酷な戦場に送る必要がないのだ。

しかも、その人間は間違いを犯す生き物で、機械ではないからといって戦争犯罪と無縁なわけでもない。その点機械なら、どのような状況でも常に冷静で、適法な対象だけに攻撃を仕掛けることだろう。

しかし、この議論には致命的な欠陥がある。合法であることと正しいことが常に同じとは限らないからだ。

Computerizer from Pixabay

法と正義、どちらが大切か

たとえば、かつてアフガニスタンでタリバンが6歳の少女を戦場に派遣したことがあった。その子はヤギ飼いの格好で米軍に近づき、その位置をタリバンに伝えていた。

戦争法では、戦闘員に年齢の要件を定めていない。よって、その女の子はタリバンの戦闘員とみなされるのであって、米兵が射殺したとしても戦争法違反ではない。

だが現場の兵士はそのように考えないだろう。子供を殺すのは人の道に外れることだと考える。

ところが機械は戦争法に従うようプログラムされており、子供を殺害することが善か悪かを考えたりはしない。

ときに生身の兵士は法律よりもずっと悪いことをするが、反対にいいことをすることもある。法律だけでなく、道徳によっても規律された人間ゆえのことだ。

ならば、戦争法に従い、それに反するような命令を拒否するようプログラムしつつ、同時に人の命を奪う際は人間の監督を必要とする——そんな兵器だって作れるはずだ。

だが現実には、LAWSの開発は完全な自律型へと向かっている。

強力かつ低コストな兵器の問題性

完全なる自律型兵器は楽に低コストで人を殺せる。だが、その帰結は恐ろしいものだ。

まずLAWSの開発が続けば、いずれはかなりの低コスト化が実現されるだろう。なにしろ今日でさえ、手頃な価格のドローンを一般人が入手できるのだ。

もし、戦場でそんな戦闘ドローンがテロリストの手に渡ったら? 彼らは、それを容易に大量生産できるようになる。

LAWSはまた民族浄化やジェノサイドをきわめて効率的にやってのけるだろう。そのような行為を望む人間は、特定の人種をターゲットの要件に入力するだけでいい。

そしてもちろん、例の心配もある。すなわちAIが人類に対して反乱を起こし、私たちを駆逐するという可能性だ。

Computerizer from Pixabay

透明な開発プロセスが必要

そんな危険性があるからこそ、AIの開発は公開されながら行われるべきなのだ。極秘に開発されていたのでは見落としてしまうような欠陥も、大勢の目に触れれば発見される可能性は高くなる。

そして何より開発に焦らないことが大切だ。ところが、困ったことにそれが起こりやすい分野がある――軍事である。

現時点においてAI技術で最先端を行っているのは米国だ。その米国がAI兵器の優位性を過度に振りかざすようになれば、他国もまたAI開発に注力するようになるだろう。開発競争の勃発だ。

AIによる過ちはそうした状況で最も起こりやすく、かつ最も危険なものとなる。

生物兵器禁止条約の先例

殺人ロボットへの対抗策の文脈で指摘されるのが、かつて生物兵器の使用が禁止され、これがかなり成功していることだ。

生物兵器はその開発が進み、危険性が認識されるようになったことから、1972年に生物兵器禁止条約の署名が開始され、1975年に発効された。

これに成功した背景にはいくつか要件があった。まず、国家が生物兵器によってそれほどメリットを得られなかったことがある。やたらと安価でしかも容易に入手できる大量破壊兵器など、国家にとっては厄介なだけだ。

LAWSに関しても、同じことが主張されている。たとえば核兵器の拡散防止に苦労してきたこの70年を振り返ってみるといい。LAWSで同じようなことが繰り返されるのは、政府も望まないはずだ。

Computerizer from Pixabay

議論が進まない理由

ところが国連の場でこれに関する議論はなかなか進んでいない。

その要因としては、まずそもそも多国間条約の議論とは一般にゆっくりとしたものだということが挙げられる。だが、技術の発展は非常に急速で、議論がついていけない。

もう一つ、より重要なことに、そうした条約に反対する国があることが挙げられる。米国もそうした国で、反対の理由については、LAWSには人道的な側面があり、この点を検討する前に禁止するのは時期尚早だとしている。

無論、禁止派の声も根強い。LAWSをいつまでも国家の軍隊だけのものにしておくのは至難の技だろう。いずれは国家以外のグループの手に渡る可能性が大きい。そうなる前に禁止をするべきであるし、いずれ禁止するのだとしたら実用化される前にした方がずっと容易だ。

またAIの研究者にも、自分たちの開発した技術が軍事利用されることに強い抵抗感を示す人たちがいる。

かつてグーグルが国防総省のメイヴァン計画に関与していることが明らかになったとき、従業員が大反対し、結局計画はお蔵入りとなったことがある。同様に、マイクロソフトの従業員も、自分たちの技術の軍事利用を拒んだ。

私たちは危険な未来を回避できるのか?

殺人ロボットは潜在的に非常に危険な代物だ。全体主義国家や非国家主体の手に渡ってしまえば、恐ろしい事態になることは目に見えている。

同時にLAWSはより大きな流れの一部だとも言える。AIはかつて不可能だったことを可能にした。それは人間の認知能力を超え、今後もますます強力なものになっていくだろう。

今、それが自律兵器であれ、裁判の判決を下すものであれ、私たちは社会の重要な機能をよく理解されておらず、人間のことなどさして考えていないかもしれない機械に委ねようとしている。

完全なAIはまだ登場していないが、私たちはその日の到来に備えておかなければならない。それも映画の中の出来事が現実になってしまう前に――。

References:Death by algorithm: the age of killer robots is closer than you think - Vox/ written by hiroching / edited by parumo

あわせて読みたい

アメリカは中国の宇宙レーザーを回避するため、AIを搭載した高性能人工衛星を開発しようとしている

アメリカは中国の宇宙レーザーを回避するため、AIを搭載した高性能人工衛星を開発しようとしている AIの専門家が殺人ロボットの開発を禁止するよう政府に訴え

AIの専門家が殺人ロボットの開発を禁止するよう政府に訴え 殺人ロボットの開発は来てるところまで来ている。もはや制御不能(米研究)

殺人ロボットの開発は来てるところまで来ている。もはや制御不能(米研究) 進化する人工知能ラブロボットに専門家が警告。ハッキングされたら所有者を襲う「キラー・ラブロボット」になる可能性

進化する人工知能ラブロボットに専門家が警告。ハッキングされたら所有者を襲う「キラー・ラブロボット」になる可能性 アメリカ国防総省は真剣にAIとの戦争を恐れている。”ターミネーター”の登場に備えるべく研究を進めるペンタゴン

アメリカ国防総省は真剣にAIとの戦争を恐れている。”ターミネーター”の登場に備えるべく研究を進めるペンタゴンこの記事が気に入ったら

いいね!しよう

いいね!しよう

カラパイアの最新記事をお届けします

「知る」カテゴリの最新記事

「サイエンス&テクノロジー」カテゴリの最新記事

この記事をシェア :

人気記事

最新週間ランキング

1位 2775 points |  | お宝発見!と思いきや、黄金に輝くその物体は蝶のサナギだった!(※蝶一族出演中) |

2位 2578 points |  | またしてもタコの凄さが露呈。8本の触手は脳からの指令がなくても独立して意思決定ができる(米研究) |

3位 2056 points |  | ふてくされ顔が魅力のマヌルネコ先輩。その赤ちゃん2匹がもうすぐ那須どうぶつ王国で一般公開!(栃木県) |

4位 1989 points |  | 緑色のハチドリかな。と思ったら植物だった!ハチドリそっくりに見えるオーストラリアの花「グリーン・フラワーバード」 |

5位 1429 points |  | 悲報かな。脅威の繁殖力を誇るチャバネゴキブリの耐性が更にアップ。殺処分不能な超進化を遂げつつある(米研究) |

スポンサードリンク

551

551 2110

2110 40

40 74

74

コメント

1. 匿名処理班

過去、新しい兵器が出来るたびに「この新兵器は、相手を圧倒するので、そもそも戦争にならない、つまり人道的だ」と何度も言われてきた、マシンガン、戦車、ガス兵器など。

だが、人道的な兵器などないのだ。

2. 匿名処理班

人間はミスを教訓にする事はできるけど、前例のないミスを予防する事は苦手だからなあ。

AIによる大量破壊が起きてからじゃないと行動できない気がする。

3. 匿名処理班

100年後の人類に恨まれるのかもね、僕らは

4. 匿名処理班

以前も科学者たちが、完全自律の殺人兵器がまだ実用化されてないのに禁止しろと騒いだって記事があったけど

あれは「まだ世に出ても居ないものを禁止しろと意味不明なことを言っている」のではなく

「そういうものが実現するのはヤバ過ぎるから実現させちゃいけない」という話だというのは

世間はあんまり理解してなかったね

5. 匿名処理班

>完全なAIはまだ登場していないが、私たちはその日の到来に備えておかなければならない。それも映画の中の出来事が現実になってしまう前に――。

どうやって?

不可能でしょ

一番肝心なことが抜けている

6. 匿名処理班

敵味方識別がそんなに容易なのかね?

先進国軍でも普通にFFしてるが

民間人にビーコン持たせるとかは出来ないからよりガチで画像識別だけだろうし

7. 匿名処理班

結局のところ人類の未来は今までのようにお互い憎しみ合いAIを利用して戦い滅んでいくか、反乱したAIを人類共通の敵として団結し戦い滅んでいくかの違いではなかろうか

8. 匿名処理班

想像していたのとちょっと違った。

アルゴリズムによる死なんていうから、論理爆弾叩き込んで殺人ロボットを次々と機能停止させていくロボットキラーでも完成したのかと。

9. 匿名処理班

例えば 死刑の執行スイッチをAIに制御させるのは人道的?戦争行為の中で考えると哲学的命題っぼくなるけれど 身近な国内の問題に置き換えたら簡単に答えが出てきそうで怖いわ…

10. 匿名処理班

今の戦争も、やっぱり人を殺したくない一心で、

あえて敵に当たらないように、弾幕を張って牽制しあってるだけの場所は多々あるはず。

こういう、人道的にサクッと殺す兵器を投入したら、

戦局はどうなってしまうのだろう。

11. 匿名処理班

人間を越えるコンピューターを作るって事は、コンピューター支配の世の中になる恐れは必ずつきまとうからなぁ。

12. 匿名処理班

AIという完璧な神を造るために人類は存在するのかも

慈悲深い神だといいけど

13. 匿名処理班

抑止力としてキラーロボットのロボットキラーも同時進行で作っておいて欲しい。本部と通信してるなら可能だと思う知らんけど。

14.

15. 匿名処理班

なんだかなあ。

そうまでして戦争=人殺しをしたいもんかね?

どうせなら当事国同士で月かなんかに兵器ロボット派遣して勝手に好きなだけ勝負すれば良い。

それなら実害もないし、いらん環境破壊も避けられる。

それじゃロボットスポーツか。

16. 匿名処理班

こういうのな。小難しく考えてるけど、例えばその辺にあるプレス機に誤って挟まれたりする事故あるだろ。人工知能とか言って何故か完璧な物をイメージしがちだけど、突き詰めりゃプレス機に挟まるのと同じなんだよ。

17. 匿名処理班

※1

絶対的に人道的な兵器はないかも知れないが、相対的に人道的な兵器はあるだろ

100%無くす方法が見いだせないなら現実的選択肢として、それを選ぶのは不幸な結果を内包していようが最善手なんだよ

否定論を展開するのは自由だけどそれがより不幸な結果をもたらさないことを祈るしかないわ

18. 匿名処理班

ホライゾン・ゼロドーンの世界も夢じゃない

19. 匿名処理班

敵味方識別チップを味方の体内に入れておけばあとは殲滅するだけの簡単なお仕事です

20. 匿名処理班

いよいよスカイネット誕生か